DeepSeek R1与OpenAI模型文风相似度高达74.2%?新研究质疑DeepSeek训练数据

DeepSeek R1与OpenAI模型文风相似度高达74.2%?新研究质疑DeepSeek训练数据在 DeepSeek 生成的文本中,有 74.2% 的文本在风格上与 OpenAI 模型具有惊人的相似性?这是一项新研究得出的结论。这项研究来自 Copyleaks—— 一个专注于检测文本中的抄袭和 AI 生成内容的平台。

在 DeepSeek 生成的文本中,有 74.2% 的文本在风格上与 OpenAI 模型具有惊人的相似性?这是一项新研究得出的结论。这项研究来自 Copyleaks—— 一个专注于检测文本中的抄袭和 AI 生成内容的平台。

3月3日,智谱公布了最新一轮融资:本轮战略融资金额超10亿元人民币,参与投资方包括杭州城投产业基金、上城资本等。智谱称:此次融资旨在推动智谱国产基座GLM大模型的技术创新和生态发展。

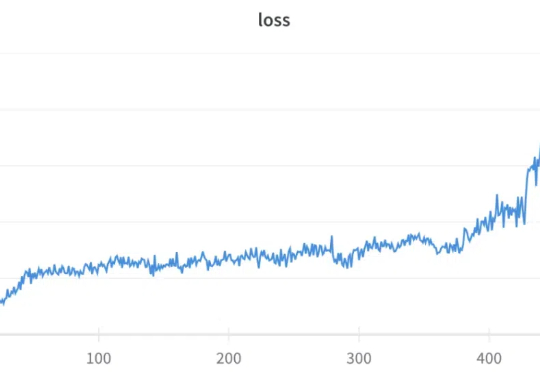

GRPO(Group Relative Policy Optimization)是 DeepSeek-R1 成功的基础技术之一,我们之前也多次报道过该技术,比如《DeepSeek 用的 GRPO 占用大量内存?有人给出了些破解方法》。

风险投资行业中,古典 VC 在科技创新浪潮中捕捉机会追求胜率,讲究品牌效应、二八原则和师徒传承。过去几年,VC 行业集体丧失贝塔,无法抓住阿尔法的 VC 已经被汰换,传统 VC 模式的弊端也逐渐暴露。VC 模式的换代迎来了 Deepseek 时刻。

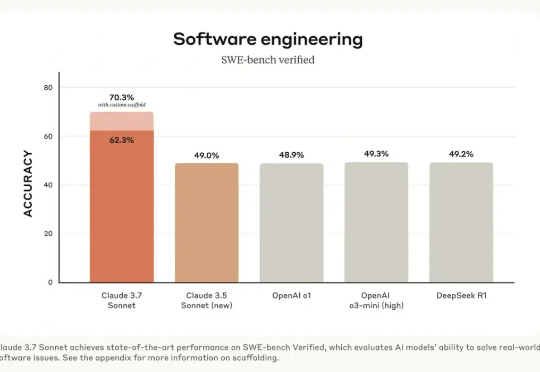

昨天,Claude 3.7 Sonnet 正式发布。根据目前的各项测评,这个模型可以说是全宇宙最好的代码生成模型,超越了 DeepSeek R1 和 OpenAI 的 o3 等模型。如果你是程序员,一定要第一时间切换过去,用下这款模型。

上周末,一则来自北京某医院神经外科主任医师的视频引发关注。据这位医师介绍,他曾用 DeepSeek 协助诊断了一位超复杂脑瘤患者的病情,并给出了超高评价:“对于这种较为深入的医学问题,DeepSeek 至少展现出了与省级三甲医院专家相当的水平。”

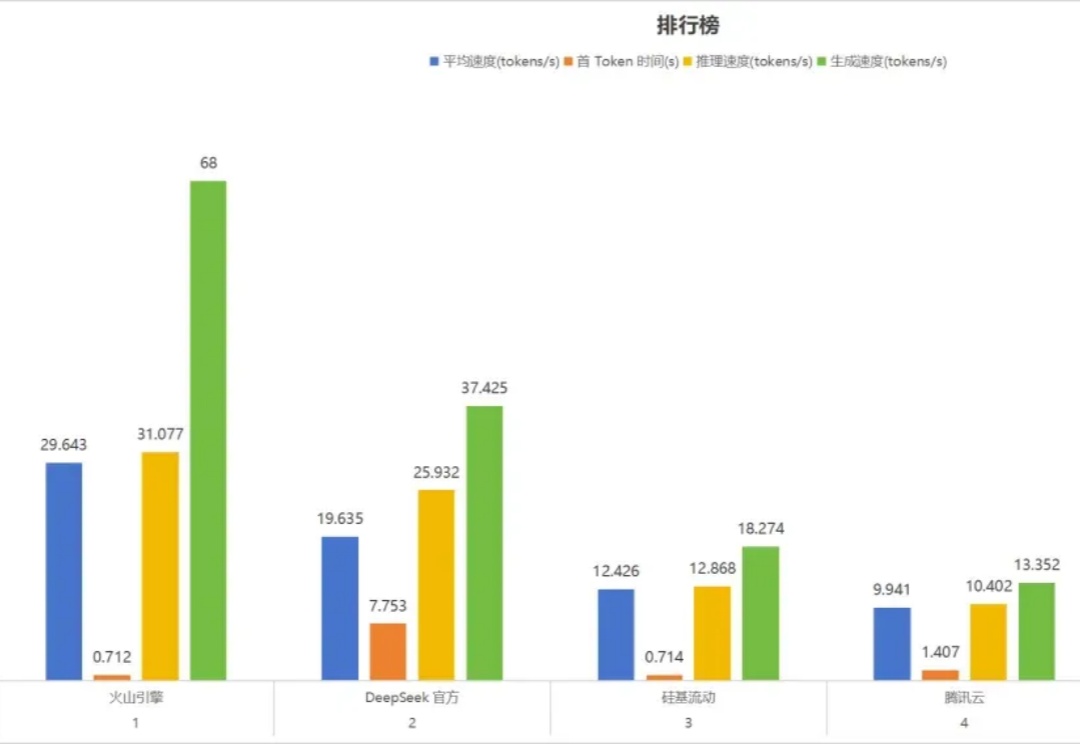

部署 DeepSeek 系列模型,尤其是推理模型 DeepSeek-R1,已经成为一股不可忽视的潮流。

这一波 DeepSeek 的泼天流量,各种大小公司都在吃。为什么,一夜之间,所有产品都在宣传自家接入了 DeepSeek 呢?主要原因是 DeepSeek 官网无法满足全世界人民日益增长的 DeepSeek 使用需求。

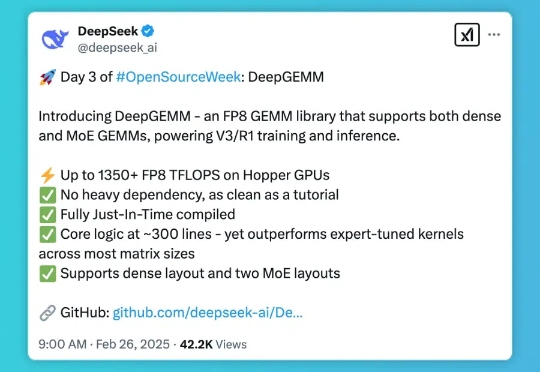

DeepSeek 开源周的第三天,带来了专为 Hopper 架构 GPU 优化的矩阵乘法库 — DeepGEMM。这一库支持标准矩阵计算和混合专家模型(MoE)计算,为 DeepSeek-V3/R1 的训练和推理提供强大支持,在 Hopper GPU 上达到 1350+FP8 TFLOPS 的高性能。

知名 Chatbot 及各种 AI 工具箱产品 Monica 最近推出了国内版Monica.cn,基于 DeepSeek R1 与 V3模型,并且具备实时联网搜索与记忆能力。